lg aimers 5기 과정을 마치며

참여하게 된 계기

si 퇴직후 몇개월 동안 공부만 하며 취준하다 지쳐있을 때 쯤 여자친구가 lg aimers 교육을 추천했다.

파이썬, 머신러닝을 언젠간 공부해야지 공부해야지 하면서 망설이던 차에 java 공부도 지치고 개인 프로젝트도 마침 끝나서 신청하게되었다.

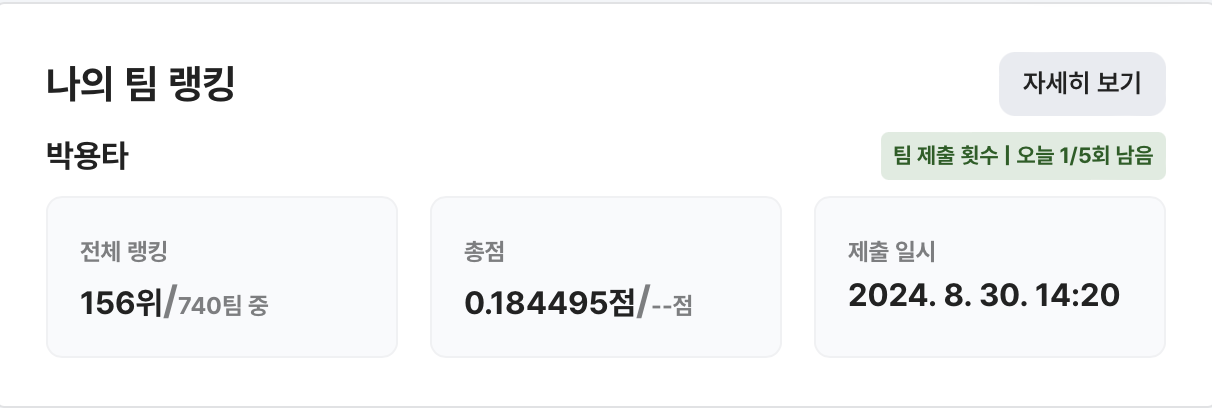

결론적으로 온라인 해커톤 740팀 중 156위로 마무리됬다.

교육은 다음과 같이 구성된다.

1. 온라인 교육(1달)

2. 온라인 해커톤(1달)

3. 오프라인 해커톤/상위 100명 대상 (1박2일)

1. 온라인 교육

머신러닝, 딥러닝 이론에 대해서 배우고, 추가적인 수학이나 제조 데이터 분석에 대한 것도 배운다.

인강처럼 코딩을 하거나 실제로 진행하면서 하는 강의들은 아니여서 강의에서는 어떻게 분석하고 전처리하는지는 알 수 없었지만

lg aimers 측에서 지난 기수들의 해커톤 코드들을 제공해줘서 따로 공부할 수는 있었다.

기본적으로 수학적 지식은 다 가지고 있다고 가정하고 교육을 진행하기때문에 수학을 알면 더 좋다. 그렇지만 모른다고 못할정도는 아니다.

2. 온라인 해커톤

2.1 과제

자동차 디스플레이의 불량 여부를 판단하는것이 목표였다.

등수는 public/private 부분으로 나뉜다.

하루 5번의 제출 제한이 있었고, 마지막으로 제출한 파일이 내 최종 점수가 되었다.

팀은 최대 5명까지 꾸릴 수 있었다.

2.2 어떻게 결과를 냈는가

데이터 전처리 후 catboost,lightgbm 모델을 soft voting 앙상블하는 방식을 사용했다.

2.3 아쉬운점

- 지금와서 생각해보면 파라미터 튜닝에 시간을 너무 쏟은것이 아쉽다. 한순간이지만 덕분에 public은 9등까지 도달했었는데 그로인해 파라미터 튜닝에만 집착하게 되었고, 이후 뒤늦게 private 점수를 챙기려 하니 점수가 많이 떨어졌다.

- 추가적인 전처리를 하면 할수록 등수가 내려가는것을 보고 진작에 포기한것

다시한다면 튜닝은 최대한 건드리지 않고 데이터 분석과 전처리방식에 많은 시간을 투자하고 어떻게 과적합을 더 줄일지 고민하겠다.

- public 점수가 가장 높았던 결과를 제출하는게 좋았을까? 하는 아쉬움

가장 public이 높은 결과물, 과적합이 가작 적을것으로 예상한 모델중 가장 public 점수가 높았던 결과물 사이에서 고민하다가 결국 후자를 택했는데, 100등이 떨어진다고해도 현재 등수보다는 높았다고 생각하게 되니 많이 아쉽다. 물론 너무 과적합되어 100등 이상으로 떨어졌을 확률도 크다.

2.4 무엇이 부족했나

- 어떤 지표로 모델을 설정해야하는지 몰랐다. 과적합이 뭔지는 알았지만, 현재 내 모델이 과적합인지 판단할 능력이 부족했다.

- 막바지에서는 k-fold f1평균 점수와 전체 훈련데이터를 이용한 f-1스코어 의 차이를 비교하여 과적합 여부를 추정했다.

개인적으로는 두 점수의 차이를 0.1이하로 맞추려 노력했다. ( 그럼에도 130등/156등 으로 큰 차이가 났다.)

무엇을 배웠나

과적합여부에 따라서 private 등수가 올라갈지 내려갈지가 결정된다.

과적합 여부를 알기위해 교차검증이 필요하다.

현재 수준에서 단순 전처리와 모델 선정만으로는 벽이 존재한다. 돌파구가 필요하다.

처음 시작할때 예상한 결과에 비하면 156등은 준수한 결과이지만 순간이지만 좋은 등수를 받아보니 아쉬움과 욕심이 생긴다.

데이콘과 Keggle 에서 두자릿수 등수를 목표로 공부하고싶다는 욕심이 생겼다.